OVHcloud ofrece GPU de última generación para gestionar cargas exigentes de IA

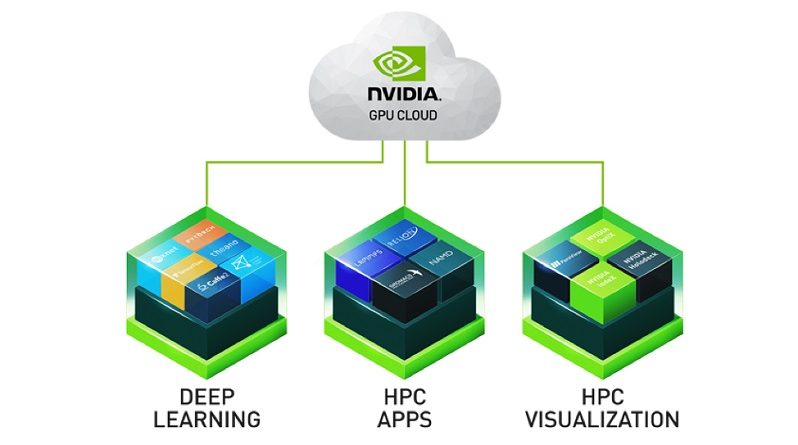

Como miembro de la nVidia Partner Network, el proveedor de nube OVHcloud continúa ampliando su cartera de soluciones de IA con la incorporación de nuevas gamas de GPU nVidia como parte de su visión estratégica de la inteligencia artificial. Consciente del enorme impacto que la IA tendrá en los próximos años, OVHcloud declara que “tiene la misión de ayudar a sus clientes a desarrollar su negocio en torno a un ecosistema de soluciones de IA innovadoras, sencillas y asequibles, basadas en modelos transparentes, éticos y abiertos que preserven la confidencialidad de los datos”.

Con más de 20 años de experiencia en infraestructuras, a través de un modelo industrial propio integrado verticalmente, OVHcloud está desarrollando infraestructuras diseñadas para IA que incluyen las nuevas GPUs nVidia H100 y A100 Tensor Core, las mejores de su clase. Los clientes podrán elegir entre una gama de soluciones para impulsar sus cargas de trabajo de aprendizaje automático más ambiciosas, incluidos los grandes modelos de lenguaje (LLM).

Como complemento a las competitivas y populares nVidia V100 y V100S de generaciones anteriores, el grupo acaba de anunciar nuevas ofertas basadas en las siguientes GPU de nVidia: H100, A100, L40S y L4, con un despliegue efectivo en las próximas semanas.

A100 para entrenamiento de deep learning

Las nuevas instancias nVidia A100 de 80 GB ya están disponibles y permiten a los especialistas en IA ejecutar proyectos complejos en los Tensor Cores altamente especializados de nVidia. Con una capacidad de entrenamiento excepcional para el aprendizaje profundo, la A100 también es ideal para la inferencia gracias a varias optimizaciones realizadas para estas cargas de trabajo que integran proyectos LLM.

La computación de alto rendimiento es otra área en el que las instancias GPU A100 contribuirán con la próxima generación de descubrimientos a través de simulaciones avanzadas, gracias a su rendimiento de computación de doble precisión y memoria de gran ancho de banda.

Las instancias A100 de nube pública pueden configurarse como A100-180 con 1x A100, 15 vCore y 180 GB de RAM, A100-360 con 2x A100, 30 vCore y 360 GB de RAM y A100-720 con 4x A100, 60 vCore y 720 GB de RAM.

H100 para IA generativa

OVHcloud también anuncia nuevas instancias GPU basadas en H100 que incorporan los últimos avances de nVidia, con 26 PetaFlops (FP64) de potencia de cálculo por GPU PCIe. Diseñada específicamente para los modelos de IA más exigentes, nVidia H100 es otra elección de referencia para la innovación en IA, ya sea para acelerar LLM con su Transformer Engine o para crear aplicaciones de IA generativa.

Para los casos de uso más complejos, especialmente en el ajuste fino y en el entrenamiento, el grupo ofrecerá soluciones basadas en H100 SXM. Con una capacidad de cálculo de 67 TeraFlops (FP64) y un mayor ancho de banda de GPU, esta oferta demostrará toda la potencia de la arquitectura de GPU nVidia Hopper.

Servidores Bare Metal con nVidia L4 y L40S

El grupo galo también ha anunciado nuevas instancias GPU dotadas de GPU nVidia L4 con 24 GB de memoria. La L4 se basa en la arquitectura de GPU Ada Lovelace de nVidia y es una GPU universal apta para todo tipo de cargas de trabajo con funciones mejoradas de IA y vídeo. Este chip proporciona recursos de cálculo óptimos en escenarios de gráficos, simulación, ciencia de datos y análisis de datos.

La GPU L40S, lanzada recientemente por nVidia, se une a las actuales GPU de la compañía en configuraciones de 48 GB de memoria para aprovechar los Tensor Cores de cuarta generación y el FP8 Transformer Engine, proporcionando un sólido rendimiento en tareas relacionadas con la IA como el entrenamiento y la inferencia.

Estas nuevas referencias de GPU estarán disponibles en instancias de nube pública y en servidores baremetal dedicados: la L4 se unirá a la gama Scale-GPU y L40S a la gama HGR-AI.

Potenciar la experiencia de los clientes

Gracias a esta selección de arquitecturas GPU nVidia, OVHcloud ofrece ahora una infraestructura diseñada para la IA que permite a ingenieros, investigadores, científicos de datos y profesionales del sector aprovechar la elasticidad del cloud para satisfacer sus necesidades de entrenamiento o inferencia en un modelo IaaS.

Además, OVHcloud añadirá gradualmente las opciones nVidia H100 y A100 a su conjunto de soluciones AI PaaS diseñadas para soportar el ciclo de vida de los datos: AI Notebooks, AI Training y AI Deploy. Las soluciones de IA de OVHcloud proporcionan un conjunto completo de herramientas potentes y fáciles de usar para explorar datos, entrenar modelos o servirlos en producción.

“La IA transformará seriamente el negocio de nuestros clientes y estamos en una posición ideal para ayudarles a realizar fácilmente esta transición hacia una nueva era. Con una infraestructura de IA única que aprovecha nuestra experiencia y las GPU más solicitadas, ofrecemos un rendimiento de primera clase con todas las ventajas del cloud. Nuestros clientes de soluciones de IA también se beneficiarán de estas novedades a través de nuestras sencillas ofertas AI Notebooks, AI Training y AI Deploy”, afirma Michel Paulin, CEO de OVHcloud.

Por su parte, Matthew McGrigg, director de desarrollo global para partners cloud de nVidia, ha señalado que “las empresas buscan servicios y opciones flexibles en la nube para impulsar la innovación internamente y ayudar a sus clientes a adoptar nuevas aplicaciones de IA generativa. Al ofrecer una gama completa de soluciones de computación aceleradas por nVidia, OVHcloud admite una gran variedad de cargas de trabajo, desde la inferencia hasta el entrenamiento”.

Precio y disponibilidad

Las instancias GPU basadas en nVidia A100 ya están disponibles en Public Cloud a partir de 2,75 euros/hora para A100-180, 5,50 euros/hora para A100-360 y 11 euros/hora para A100-720. Las soluciones de IA gestionadas basadas en A100 estarán disponibles más adelante a partir de 3 euros/hora.

Las instancias nVidia H100 PCIe en Public cloud se lanzarán a finales de este otoño, con reservas anticipadas desde este momento. Los clientes interesados en las próximas ofertas de nVidia H100 SXM pueden solicitar un presupuesto personalizado.

Las instancias GPU nVidia L4 y L40S estarán disponibles en octubre. El lanzamiento de los nuevos servidores baremetal con nVidia L4 y L40S está previsto para este otoño.

Igualmente siguiendo su hoja de ruta dedicada a la IA, OVHcloud anunciará en próximas semanas una nueva oleada de innovaciones diseñadas para ayudar a sus clientes a navegar por este nuevo paradigma.