Las implicaciones de los LLM en la ciberseguridad

TPB344 abr24. La inteligencia artificial (IA) ofrece un gran potencial de automatización y ahorro de costos. Sin embargo, ¿es segura la IA? Los grandes modelos de lenguaje (LLM) están arrasando en todo el mundo. Fundada en 1997 y con sede en Montreal (Canadá), Gentec se encumbra en el lado ético de la IA. Aquí responde algunos por qués.

APENAS UNOS meses después de que OpenAI lanzara su chatbot de IA generativa, ChatGPT, superó los 100 millones de usuarios. Esto la convierte en la aplicación de consumo de más rápido crecimiento de la historia (dos meses) en llegar a esa cifra. No es de extrañarse el por qué. Los LLM pueden hacer de todo, desde responder preguntas y explicar temas complejos hasta redactar guiones de películas completos e incluso escribir códigos. Si bien la gente de todo el mundo está entusiasmada por esto, también está preocupada por las capacidades de esta tecnología de inteligencia artificial.

Aunque los LLM se han convertido recientemente en un tema de moda, vale la pena señalar que esta tecnología existe desde hace mucho tiempo. Aunque hay avances en marcha, los LLM y otras herramientas de inteligencia artificial están creando nuevas oportunidades para impulsar una mayor automatización en diversas tareas. Por eso, es esencial tener una comprensión fundamentada de las limitaciones y los riesgos potenciales de la IA.

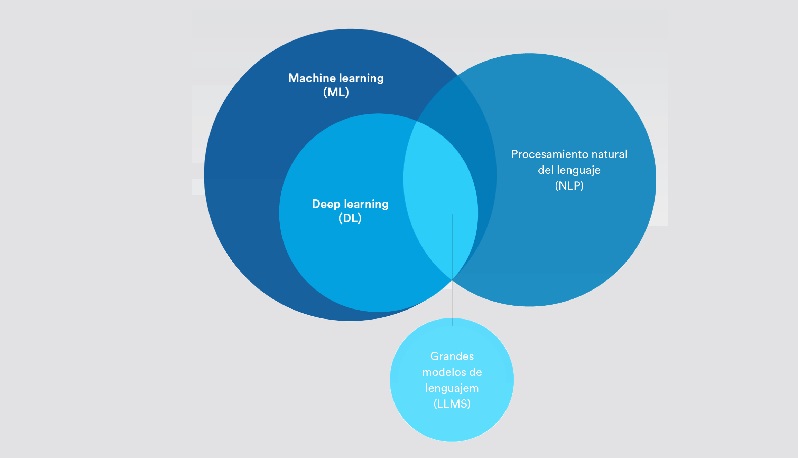

Aclaración de la terminología

Inteligencia artificial, aprendizaje automático, aprendizaje profundo: ¿cuáles son las diferencias? ¿Y cómo encajan los grandes modelos de lenguaje?

- Inteligencia Artificial (IA): El concepto de simular procesos de la inteligencia humana en máquinas. En pocas palabras, machine learning y deep learning pertenecen a la categoría de inteligencia artificial.

- Machine Learning (ML): Inteligencia artificial que puede adaptarse automáticamente con muy poca interferencia humana.

- Procesamiento de Lenguaje Natural (NLP): El proceso de utilizar inteligencia artificial y machine learning para comprender el lenguaje humano y realizar automáticamente tareas repetitivas como revisión ortográfica, traducciones y resúmenes.

- Deep Learning (DL): Se trata de un subconjunto de machine learning que utiliza redes neuronales artificiales para imitar el proceso de aprendizaje de un cerebro humano.

- Grandes Modelos de Lenguaje (MLL): Algoritmo de inteligencia artificial que utiliza técnicas de deep learning y se alimenta de cantidades masivas de información de Internet.

¿Cuáles son los riesgos de los MLL?

A principios de este año, Sam Altman, CEO de OpenAI, admitió deficiencias en torno a sesgos que pusieron en duda la seguridad de ChatGPT. Más recientemente, los investigadores descubrieron que impulsar grandes modelos de lenguaje con identidades como «mala persona», o incluso ciertas figuras históricas, genera un aumento de seis veces en las respuestas tóxicas y dañinas del modelo de machine learning.

¿Son seguros los grandes modelos de lenguaje?

Al sopesar los riesgos de los LLM, es importante considerar esto: los grandes modelos de lenguaje están entrenados para satisfacer al usuario como su primera prioridad. Los LLM también utilizan un método de entrenamiento de IA no supervisado para alimentar una gran cantidad de datos aleatorios de Internet. Esto significa que las respuestas que dan no siempre son precisas, veraces o libres de prejuicios. Todo esto se vuelve extremadamente peligroso en un contexto de seguridad.

De hecho, este método de IA no supervisado ha abierto la puerta a lo que ahora se denominan “alucinaciones de la verdad”. Esto sucede cuando un modelo de IA genera respuestas que parecen plausibles, pero que no son objetivas ni están basadas en datos del mundo real.

El uso de los LLM también puede crear graves riesgos de privacidad y confidencialidad. Este modelo puede aprender de datos que contienen información confidencial sobre personas y empresas. Dado que cada mensaje de texto se utiliza para entrenar la siguiente versión, esto significa que alguien que pregunte al LLM sobre contenidos similares podría tener acceso a esa información confidencial a través de respuestas del chatbot de IA.

Luego, están los abusos malintencionados de esta tecnología de IA. Consideremos cómo individuos malintencionados con poco o ningún conocimiento de programación podrían pedirle a un chatbot de IA que escriba un código que aproveche una vulnerabilidad conocida o solicite una lista de formas de hackear aplicaciones o protocolos específicos. Aunque estos son ejemplos hipotéticos, uno no puede evitar preguntarse cómo se podrían explotar estas tecnologías de maneras que aún no podemos anticipar.

¿Cómo están evolucionando los grandes modelos de lenguaje en el espacio de la seguridad electrónica?

Ahora que los grandes modelos de lenguaje LLM están generando mucho revuelo, existe la sensación de que la IA puede hacer que todo sea posible, como por arte de magia. Sin embargo, no todos los modelos de IA son iguales ni avanzan al mismo ritmo.

Los grandes modelos de lenguaje, de machine learning y deep learning, están generando resultados basados en probabilidades. Si analizamos específicamente y en profundidad los grandes modelos de lenguaje, su objetivo principal es proporcionar la respuesta más plausible a partir de un volumen masivo e indiscriminado de datos. Como ya lo mencionamos, esto puede provocar desinformación o alucinaciones de IA.

En el espacio de la ciberseguridad, los algoritmos de machine learning y deep learning no dependen de la IA generativa, que puede inventar información. En cambio, los modelos de IA están diseñados para detectar patrones y clasificar datos. Dado que estos resultados todavía se basan en la probabilidad, necesitamos que los humanos se mantengan informados y tomen sus decisiones finales con base en lo que es verdad y lo que no lo es.

Dicho esto, lo mismo ocurre con todos los resultados beneficiosos de los LLM. Para las aplicaciones de seguridad, podría haber un futuro en el que los operadores puedan utilizar un modelo de lenguaje de IA dentro de una plataforma de seguridad para obtener respuestas rápidas, como preguntar “¿cuántas personas hay en el tercer piso en este momento?” o “¿cuántas credenciales de visitante entregamos el mes pasado?”. También se puede utilizar para ayudar a las organizaciones a crear políticas de seguridad o mejorar detalles en sus protocolos de respuesta.

Independientemente de cómo se utilicen los modelos de lenguaje de IA, una cosa es segura: los casos de uso de seguridad requerirán enfoques en los que los modelos se ejecuten en un entorno más contenido. Entonces, si bien hay mucho entusiasmo en torno a los LLM en este momento, aún queda mucho por hacer para que sean seguros y factibles para aplicaciones de ciberseguridad.

Los LLM también utilizan un método de entrenamiento de IA no supervisado Esto significa que las respuestas que dan no siempre son precisas, veraces o libres de prejuicios, denominadas “alucinaciones de la verdad”. Todo esto se vuelve extremadamente peligroso en un contexto de seguridad

¿Cómo se está implementando la IA en el espacio de la seguridad electrónica?

Quizás los LLM sean una prioridad en este momento, pero el uso de la IA en la seguridad electrónica no es nuevo. Hay una variedad de formas interesantes en las que se utiliza la IA para soportar diversas aplicaciones. Los siguientes son algunos ejemplos de cómo se utiliza actualmente la IA en la seguridad electrónica:

- Para acelerar las investigaciones: Exploración de videos de un período específico para encontrar todas las imágenes con un vehículo rojo.

- Automatización del conteo de personas: Recibir alertas sobre los umbrales máximos de ocupación en un edificio o saber cuándo las filas de clientes son demasiado largas para mejorar el servicio.

- Detección de placas vehiculares: Rastreo de vehículos buscados, optimización del estacionamiento de empleados en oficinas o monitoreo del flujo de tráfico en las ciudades.

- Mejora de la ciberseguridad: Fortalecimiento de la protección antivirus en dispositivos utilizando machine learning para identificar y bloquear la ejecución de malware conocido y desconocido en los puntos finales.

Para la mayoría de las empresas, la implementación de la IA se reduce a un par de factores determinantes: logrando análisis de datos a gran escala y mayores niveles de automatización. En una época en la que todo el mundo habla de transformación digital, las organizaciones quieren aprovechar sus inversiones y datos en seguridad electrónica para aumentar la productividad, mejorar las operaciones y reducir costos.

La automatización también puede ayudar a las organizaciones a cumplir con diversos estándares y regulaciones de la industria y, al mismo tiempo, reducir el costo del cumplimiento regulatorio. Esto se debe a que deep learning y machine learning ofrecen el potencial de automatizar el procesamiento de una gran cantidad de datos y flujos de trabajo, al mismo tiempo que dirigen a los operadores hacia información relevante. Esto les permite responder rápidamente a las interrupciones de las operaciones del negocio y tomar mejores decisiones.

Si bien la IA se está democratizando cada vez más a través de diversas soluciones de analíticas de vídeo, todavía existen muchos mitos sobre lo que la IA puede y no puede hacer. Por eso es importante que los profesionales comprendan que la mayoría de las soluciones de IA en seguridad electrónica no son adecuadas para todos.

Automatizar tareas o alcanzar un resultado deseado es un proceso para determinar la viabilidad técnica. Implica identificar las soluciones existentes, otras tecnologías que podrían ser necesarias y posibles problemas de compatibilidad que resolver u otros factores ambientales a considerar.

Incluso al evaluar la factibilidad, algunas organizaciones pueden preguntarse si la inversión justifica el resultado. Entonces, si bien la IA es un componente clave para alcanzar niveles más altos de automatización en la industria de la seguridad electrónica, todavía se requiere mucha consideración, previsión y planificación para lograr resultados precisos.

En otras palabras, es crucial ser cauteloso al explorar nuevas soluciones de IA y sopesar con pensamiento crítico y diligencia debida los resultados prometidos.

Algunas organizaciones pueden preguntarse si la inversión justifica el resultado. Si bien la IA es un componente clave para alcanzar niveles más altos de automatización, todavía se requiere mucha consideración, previsión y planificación. Es crucial ser cauteloso al explorar nuevas soluciones de IA y sopesar con pensamiento crítico y diligencia debida

¿Cuáles son las mejores formas de aprovechar la IA en la seguridad electrónica hoy en día?

Las aplicaciones basadas en IA están avanzando de maneras nuevas y apasionantes. Prometen ayudar a los negocios a alcanzar resultados comerciales específicos que aumenten la productividad, la protección y la seguridad en toda la organización.

Una de las mejores formas de aprovechar los nuevos avances de la IA en ciberseguridad es implementando una plataforma de seguridad abierta. La arquitectura abierta brinda a los profesionales de la seguridad la libertad de explorar aplicaciones de inteligencia artificial que generen el mayor valor en sus operaciones. A medida que las soluciones de IA llegan al mercado, los líderes pueden probar estas aplicaciones, a menudo de forma gratuita, y seleccionar las que mejor se adapten a sus objetivos y entorno.

Sin embargo, junto con el surgimiento de nuevas oportunidades, también surgen nuevos riesgos. Por eso es igualmente importante asociarse con organizaciones que prioricen la protección de datos, la privacidad y el uso responsable de la IA. Esto no sólo ayudará a mejorar la ciberresiliencia y fomentar una mayor confianza en tu negocio, sino que también es parte de ser socialmente responsable.

En el reporte de IBM titulado ‘AI Ethics in Action’, el 85% de los consumidores dijeron que es importante que las organizaciones tengan en cuenta la ética al utilizar la IA para abordar los problemas de la sociedad. El 75% de los ejecutivos cree que lograr una correcta ética en la IA puede diferenciar a una empresa de sus competidores. Más del 60% de los ejecutivos consideran que la ética de la IA ayuda a sus organizaciones a desempeñarse mejor en cuestiones de diversidad, inclusión, responsabilidad social y sostenibilidad.

¿Cómo Genetec considera la privacidad y la gobernanza de datos utilizando IA responsable?

Dado que los algoritmos de IA pueden procesar grandes cantidades de datos de forma rápida y precisa, la IA se está convirtiendo en una herramienta cada vez más importante para las soluciones de ciberelectrónica. Sin embargo a medida que la IA evoluciona, magnifica la capacidad de utilizar información personal de maneras que pueden invadir la privacidad.

Los modelos de IA también pueden producir, sin darse cuenta, decisiones sesgadas o resultados basados en diversos sesgos. Esto puede afectar las decisiones y, en última instancia, llevar a la discriminación. Si bien la IA tiene el poder de revolucionar la forma en que se realiza el trabajo y la forma en que se toman las decisiones, es necesario implementarla de manera responsable.

Es por eso que nuestro equipo en Genetec se toma en serio la IA responsable. De hecho, hemos ideado un conjunto de principios básicos para crear, mejorar y mantener nuestros modelos de IA. Estos se basan en los siguientes tres pilares:

- Privacidad y gobernanza de datos

Como proveedores de tecnología, asumimos la responsabilidad de cómo utilizamos la IA en el desarrollo de nuestras soluciones. Esto significa que sólo utilizamos los conjuntos de datos que respetan las correspondientes regulaciones de protección de datos. Siempre que sea posible, anonimizamos los conjuntos de datos y utilizamos datos sintéticos. También tratamos los conjuntos de datos con el máximo cuidado y tenemos en cuenta la protección y la privacidad de los datos en todo lo que hacemos. Esto incluye cumplir con estrictas medidas de autorización y autenticación para garantizar que las personas equivocadas no accedan a datos e información confidenciales en nuestras aplicaciones basadas en IA. Estamos comprometidos en brindarles a nuestros clientes herramientas integradas que les ayuden a cumplir con las cambiantes regulaciones de IA.

- Transparencia y equidad

A medida que desarrollamos y utilizamos modelos de IA, siempre pensamos en cómo podemos minimizar los sesgos. Nuestro objetivo es asegurarnos de que nuestras soluciones siempre brinden resultados equilibrados y equitativos. Parte de garantizar esto significa que probamos rigurosamente nuestros modelos de IA antes de compartirlos con nuestros clientes. También nos esmeramos en mejorar continuamente la precisión y confianza de nuestros modelos. Finalmente, nos esforzamos para que nuestros modelos de IA sean justificables. Esto significa que cuando nuestros algoritmos de IA decidan o proporcionen un resultado, podremos decirles a nuestros clientes exactamente cómo llegaron a esa conclusión.

- Decisiones tomadas por humanos

En Genetec, nos aseguramos de que nuestros modelos de IA no puedan tomar decisiones críticas por sí mismos. Creemos que un ser humano siempre debe estar al tanto y tener la última palabra. Esto porque en un contexto de seguridad ciberelectrónica, priorizar la toma de decisiones centrada en el ser humano es fundamental. Piensa en situaciones de vida o muerte en las que los humanos comprenden de forma innata los peligros en juego y realizan las acciones necesarias para salvar una vida. Las máquinas simplemente no pueden comprender las complejidades de los eventos de la vida real como lo hace un operador de seguridad, por lo que depender únicamente de modelos estadísticos no puede ser la respuesta. Esta es también la razón por la que siempre buscamos presentar los resultados de los modelos de IA de manera que un humano pueda tomar las decisiones más informadas. La IA puede generar conocimientos, pero los humanos siempre deben ser quienes tomen las decisiones.